荆州市城市管理执法委员会

荆州市城市管理执法委员会

政府信息公开

推理本钱骤降75%。gpt-oss拱手礼仪动漫在线观看用新数据类型完成4倍推理速度,80GB显卡能跑1200亿参数大模型

OpenAI在最新的开源模型gpt-oss上选用的MXFP4数据类型,直接让推理本钱暴降75%!

更惊人的是,MXFP4在把内存占用降为同规划BF16模型的四分之一的一起,还把生成token的速度进步了整整4倍。

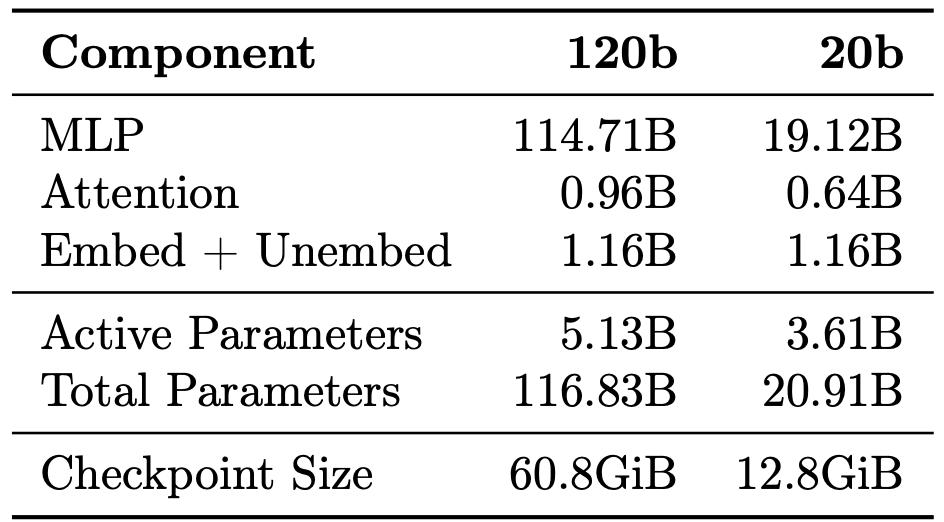

换句话说,这一操作直接把1200亿参数的大模型塞进80GB显存的显卡,哪怕是只要16GB显存的显卡也能跑200亿参数的版别。

(注:显存容量通常会大于Checkpoint Size)

比较以往的数据类型,MXFP4供给了极高的性价比,模型运转所需的硬件资源仅为之前的四分之一。

MXFP4有什么法力?

在gpt-oss中,OpenAI将MXFP4量化使用于大约90%的权重,这一操作的直接动机(收益)便是让模型运转本钱变得愈加廉价。

将gpt-oss模型量化为MXFP4 后,大言语模型的占用内存仅为等规划BF16模型的1/4,并且生成token的速度最高可进步4倍。

怎样经过改动数据类型下降模型运转本钱?这儿的逻辑是这样的:

模型的运转本钱主要由权重存储和内存带宽两个部分组成。

前者是模型参数寄存和占用的空间,也便是存储它们所需求的字节数。

后者则是模型在推理时,数据读写速度和容量的约束。

数据类型的改动将直接影响权重存储和内存带宽的占用。

例如,传统模型权重通常用FP32(32位浮点数)存储,每个参数占用4字节内存。

假如用MXFP4,那么每个权重只要半字节,权重存储巨细是FP32的1/8,这就极大地紧缩了权重数据量的巨细。

这一紧缩不只下降了模型的存储空间,还能让模型在相同的带宽下完结更快地数据读取和写入,然后进步推理速度。

由此,经过改动数据类型就能完成推理本钱的降本增效。

那么,MXFP4是怎样完成这一点的?

MXFP4

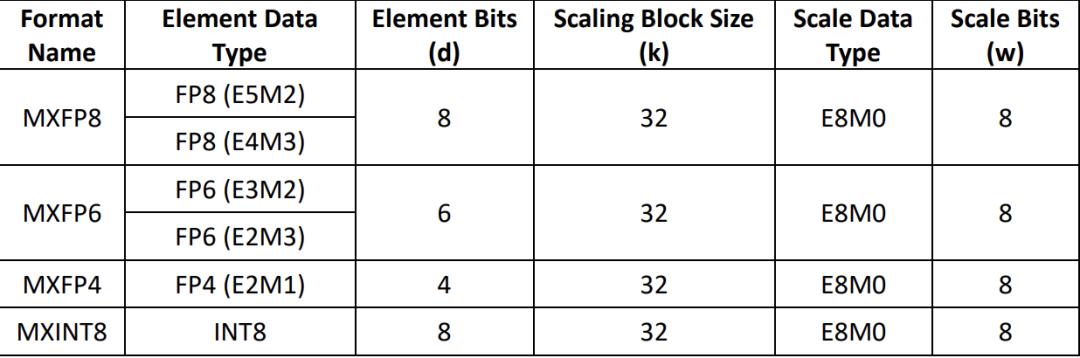

MXFP4的全称是微缩放4位浮点数(Micro-scaling Floating Point 4-bit),是由Open Compute Project (OCP) 界说的4位浮点数据类型。

(注:OCP是Facebook于2011年建议的超大规划数据中心协作安排,旨在下降数据中心组件本钱并进步可获取性。)

在深度学习范畴中,数据类型的精度和功率一直是研讨者取舍的要点。

例如,传统的FP4只要四位,1位符拱手礼仪动漫在线观看号位(标明正负),2位指数位(决议数值的量级),1位尾数位(标明小数部分)。

这种标明办法尽管紧缩了数据量,但也导致了十分有限的可标明的数值规模,它只能标明8个正数和8个负数。

相较之下,BF16(1位符号位,8位指数位和7 位尾数位)则能标明 65,536个数值,不过标明规模的添加也带来了核算本钱的上升。

假如为了进步核算功率,直接把这4个BF16数值:0.0625、0.375、0.078125、0.25直接转换成FP4,那么它们会变成 0、0.5、0、0.5。

不难看出,这样的差错显然是无法承受的。

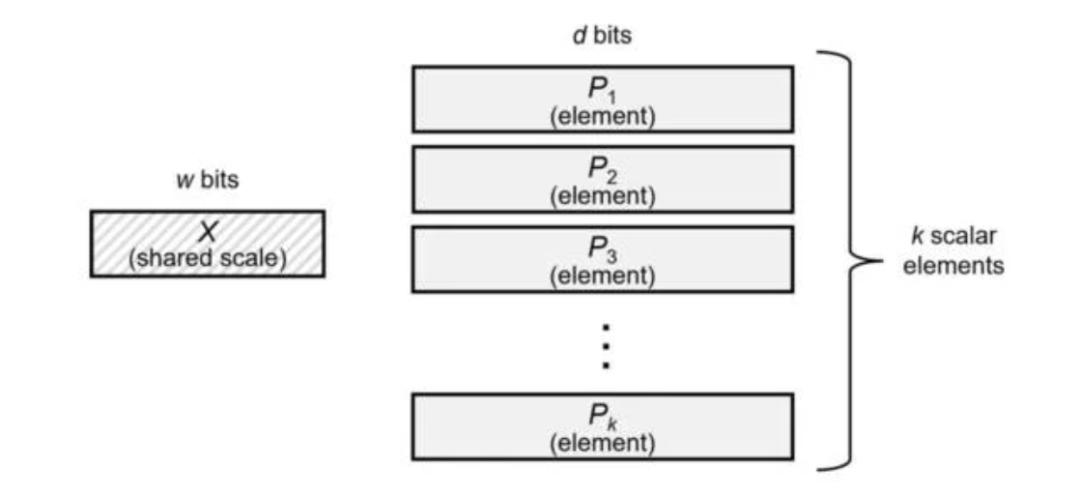

所以,为了在削减数据量的一起保证必定的精度,MXFP4经过将一组高精度数值(默许32个)乘以一个公共缩放因子(这个缩放因子是一个8位二进制指数)。这样,咱们前面那4个BF16数值就会变成 1、6、1.5、4。

这样就既完成了极致的数据巨细,又保持了数值间巨细联系的精度。

此外,这一进程的完成还与核算硬件相关。

一般规则是,每将浮点精度折半,芯片的浮点吞吐量就能翻倍。

比方,一个B200SXM模块的稠密BF16运算功能约为2.2 petaFLOPS,降到FP4(Nvidia Blackwell 芯片供给硬件加速)后,就能进步到9petaFLOPS。

尽管这会在吞吐量上带来一些进步,但在推理阶段,更多FLOPS的含义主要是削减模型开端生成答案的等待时间。

值得注意的是,运转MXFP4模型并不要求硬拱手礼仪动漫在线观看件有必要原生支撑FP4。

用于练习gpt-oss的Nvidia H100就不支撑原生FP4,不过它仍然能够运转,仅仅无法享用该数据类型的悉数优势。

低精度与核算量的取舍

事实上,MXFP4并不是新概念。早在2023年的陈述中,OCP就在陈述《OCP Microscaling Formats (MX) Specification Version 1.0》中详细介绍过这一数据类型。

但是,这种低精度的数据类型通常被以为是对性价比的退让,由于精度下降会导致质量丢失。丢失的程度取决于详细的量化办法。

不过,现已有满足多的研讨标明,将数据精度从16位降到8位,在大言语模型场景下简直没有质量丢失,这种精度现已满足支撑模型的正常作业。

事实上,一些模型开发者,例如DeepSeek现已开端直接用FP8进行练习。

此外,尽管MXFP4比规范FP4好得多,但它也有缺点。

例如,英伟达就以为这种数据类型比较FP8仍或许呈现质量下降,部分原因是其缩放块巨细(Scaling Block Size)为32,不行细粒化。

为此,英伟达推出了自己的微缩放数据类型NVFP4,经过将缩放块巨细降至16和运用FP8缩放因子来进步质量。

这简直等同于FP8的作业方式。只不过MXFP4是在张量内部的小块上使用缩放因子,而不是作用于整个张量,然后在数值之间完成更细的粒度。

最终,在gpt-oss上,OpenAI只运用了MXFP4。

鉴于OpenAI在AI范畴上的影响力,这基本上就等于在说:

假如MXFP4对咱们够用,那对你也应该够用。

参阅链接

[1]https://www.theregister.com/2025/08/10/openai_mxfp4/

[2]https://cdn.openai.com/pdf/419b6906-9da6-406c-a19d-1bb078ac7637/oai_gpt-oss_model_card.pdf

[3]https://www.opencompute.org/documents/ocp-microscaling-formats-mx-v1-0-spec-final-pdf

本文来自微信大众号“量子位”,36氪经授权发布。